🔥Come Installare Modelli AI in Locale+Plugin VS Code(Continue, Cline)

In questo tutorial completo imparerai a configurare e utilizzare i modelli di intelligenza artificiale direttamente sul tuo pc, senza dipendere da servizi cloud!

Introduzione

Nel panorama sempre più dinamico dell'intelligenza artificiale, la possibilità di eseguire modelli AI localmente sul proprio computer sta diventando una necessità per molti sviluppatori. Che si tratti di ridurre i costi, mantenere la privacy dei dati o semplicemente sperimentare con i più recenti modelli AI, questa guida vi mostrerà come configurare e utilizzare efficacemente i modelli di intelligenza artificiale in locale.

📚 COSA IMPARERAI:

▶️ Come installare e configurare DEEPSEEK in locale

▶️ Configurazione e utilizzo di Ollama per gestire i modelli AI

▶️ Setup di interfacce utente per l'inferenza AI

▶️ Utilizzo di LM Studio per chat con modelli AI

▶️ Installazione e configurazione dei plugin VS Code:

Continue: assistente AI per il coding

Cline: supporto AI durante la programmazione

Perché Installare Modelli AI in Locale?

Prima di tuffarci nei dettagli tecnici, è importante capire i vantaggi di avere modelli AI in locale:

Privacy garantita: i vostri dati rimangono sul vostro computer

Nessun costo ricorrente di API o servizi cloud

Accesso offline sempre disponibile

Personalizzazione completa dei modelli

Controllo totale sulle prestazioni e le risorse

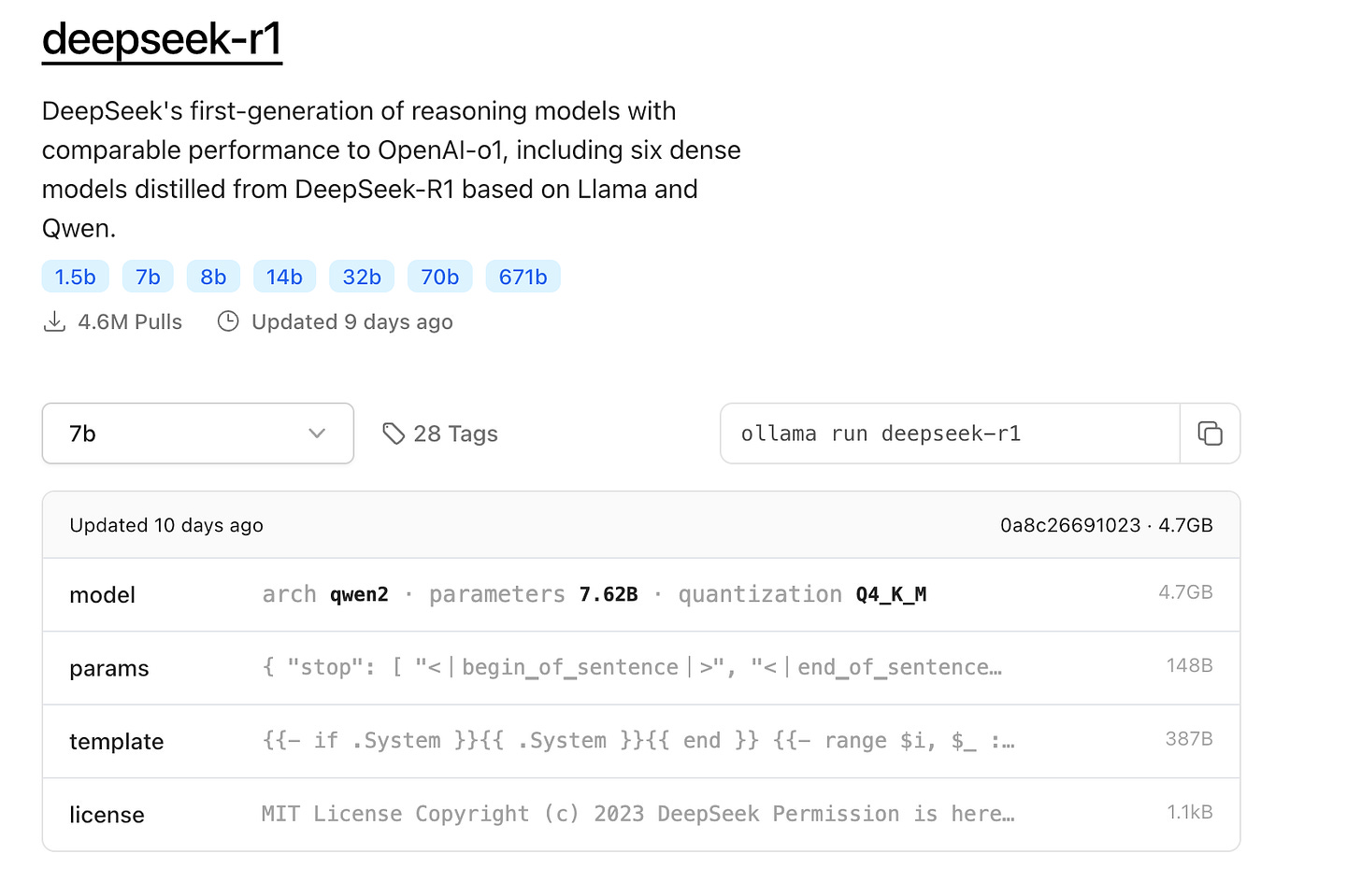

DEEPSEEK: Il Nuovo Modello AI da Non Perdere

DEEPSEEK rappresenta uno dei più recenti e potenti modelli AI disponibili per l'installazione locale. Con prestazioni che si avvicinano a quelle dei più noti modelli commerciali, DEEPSEEK offre un'alternativa gratuita e open source per:

Assistenza nella programmazione

Generazione di testo

Analisi del codice

Risoluzione di problemi complessi

Ollama: Il Gestore di Modelli AI che Semplifica Tutto

Ollama rappresenta il punto di partenza ideale per chi vuole iniziare con l'AI locale. L'installazione è semplice: basta visitare ollama.com, scaricare la versione appropriata per il proprio sistema e seguire le istruzioni di configurazione della riga di comando.

Puoi scaricarlo da quì: https://ollama.com/

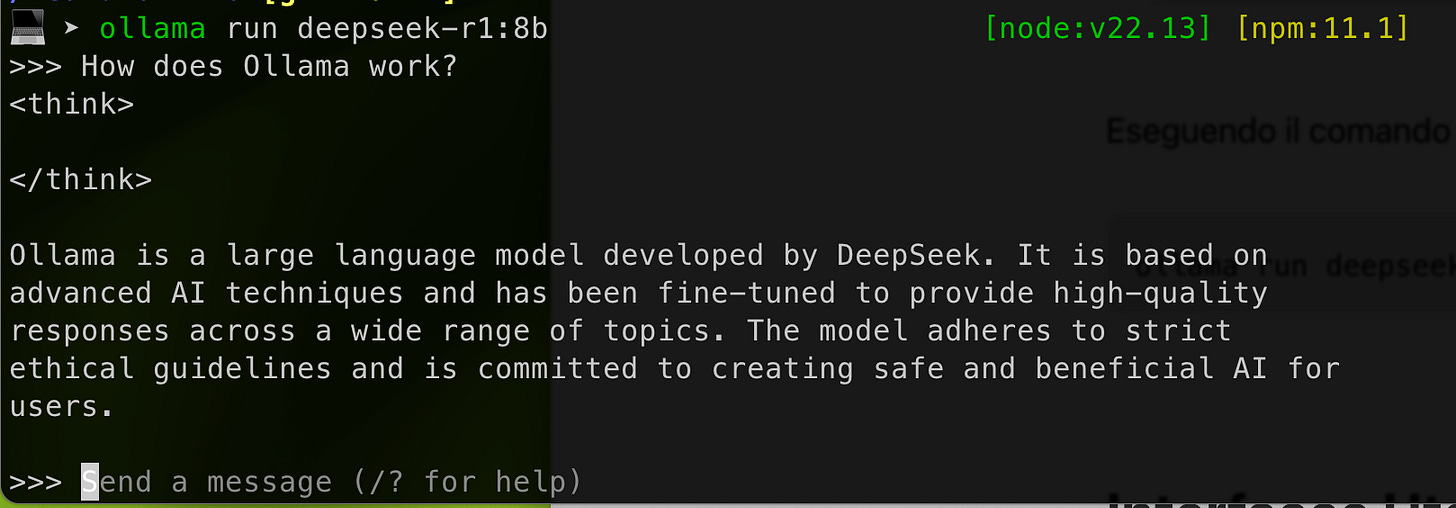

Una volta scaricato e avviato con il comando

ollama serveTrovi l’api pronta ad esporre i tuo modelli AI sotto-forma di servizio:

http://localhost:11434Su questo percorso invece trovi la lista dei modelli:

http://localhost:11434/api/tagsche ottieni anche con il comando

ollama listDal sito puoi accedere alla lista modelli e scaricare il modello di cui hai bisogno (occhio alle dimensioni)

Eseguendo il comando inizia la pull dell’immagine:

ollama run deepseek-r1Interfacce Utente per l'Inferenza AI

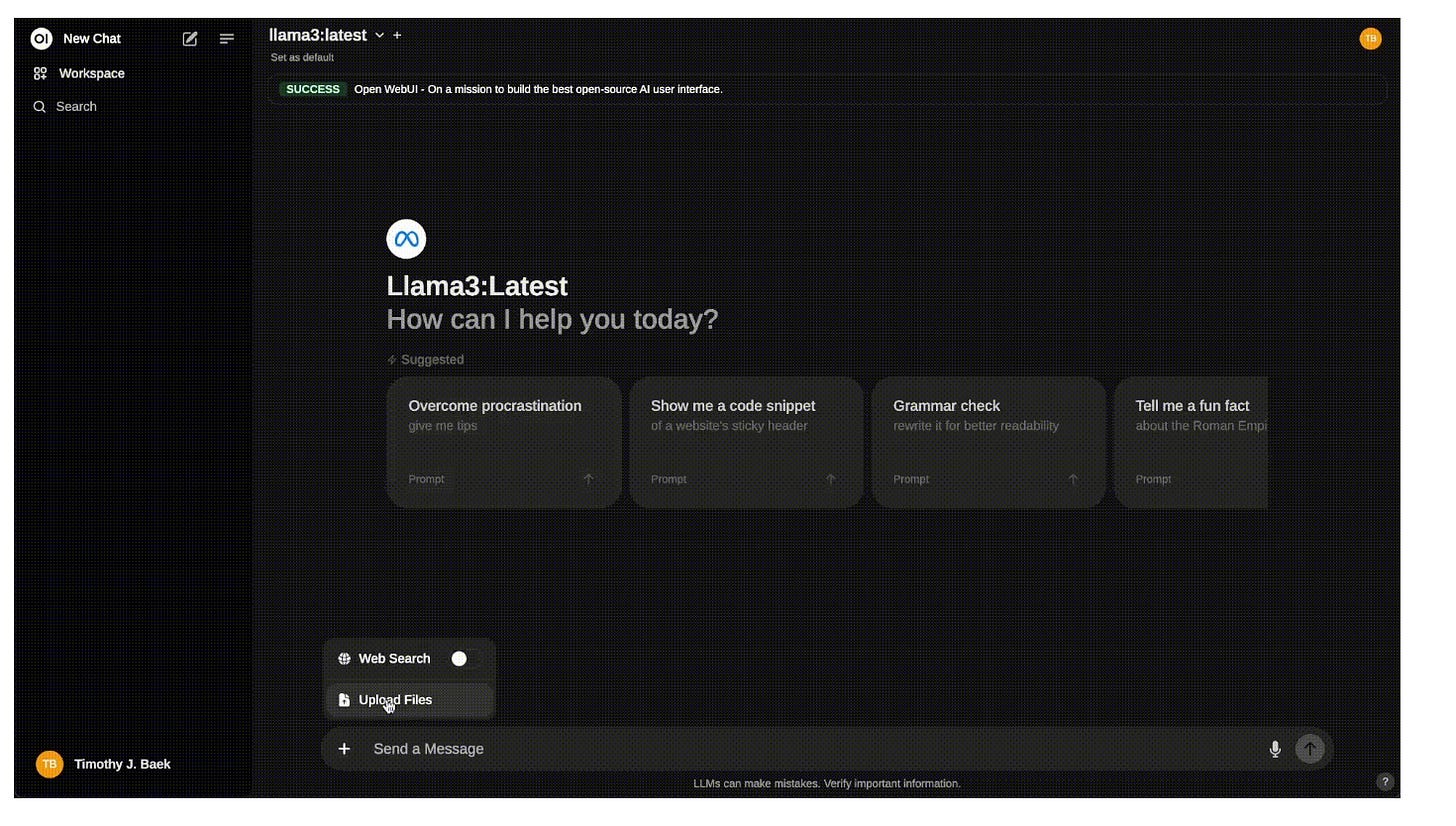

Non tutti sono comodi con la riga di comando. Per questo esistono diverse interfacce grafiche che permettono di interagire con i modelli AI in modo intuitivo. Vedremo come configurare e utilizzare le migliori UI disponibili per:

Chat interattive

Generazione di testo

Test dei modelli

Comparazione delle prestazioni

Se hai installato Ollama correttamente, attraverso questo semplice comando Docker troverai l’interfaccia di Web UI pronta ad essere utilizzata:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:mainLM Studio: Il Tuo Studio AI Personale

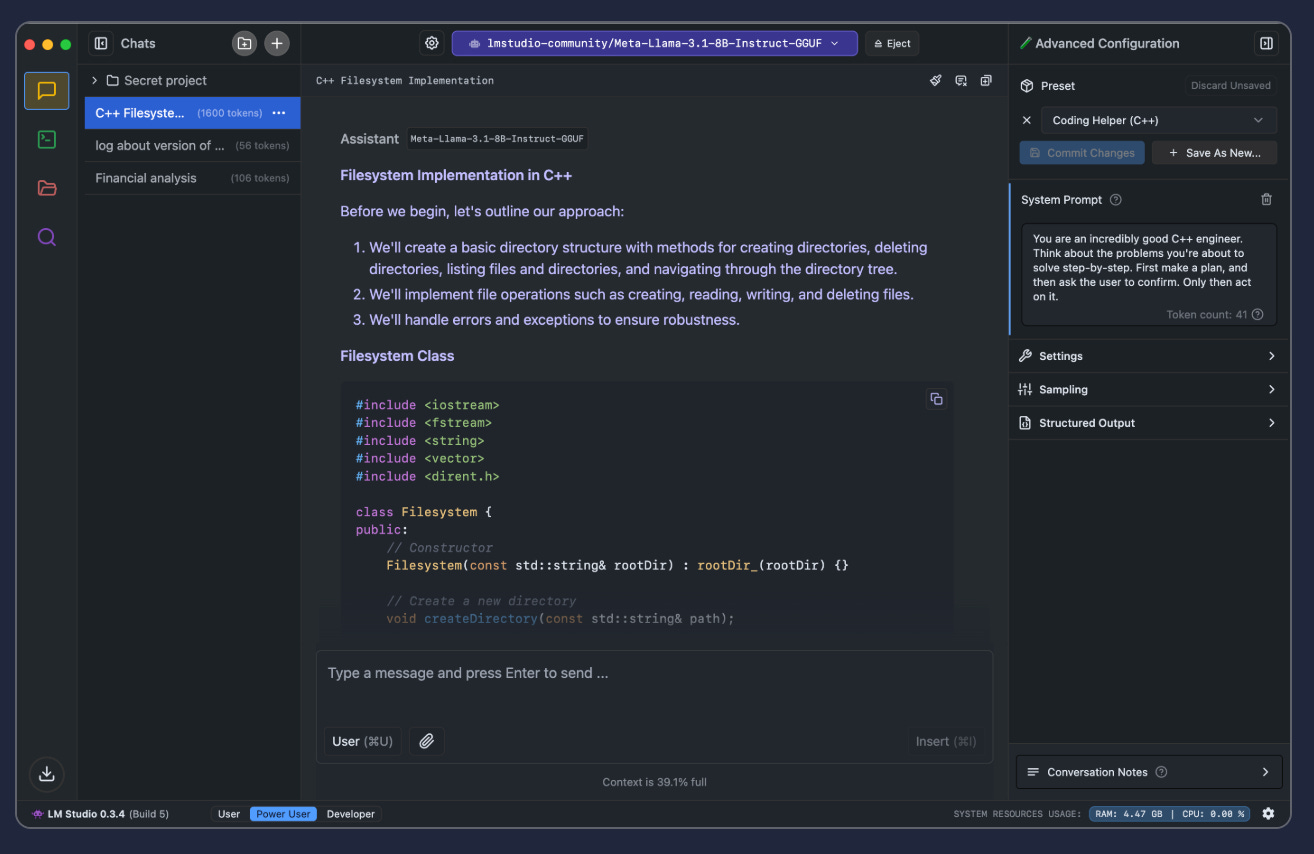

LM Studio offre un'interfaccia più sofisticata e funzionalità avanzate che lo rendono particolarmente interessante per gli sviluppatori. Tra i punti di forza troviamo:

Un'interfaccia utente intuitiva per la gestione dei modelli

Possibilità di condividere i modelli sulla rete locale

Compatibilità con le API standard di OpenAI

Configurazione dettagliata dei parametri dei modelli

Integrazione con Visual Studio Code

L'integrazione con l'IDE è fondamentale per gli sviluppatori. Due estensioni si distinguono particolarmente:

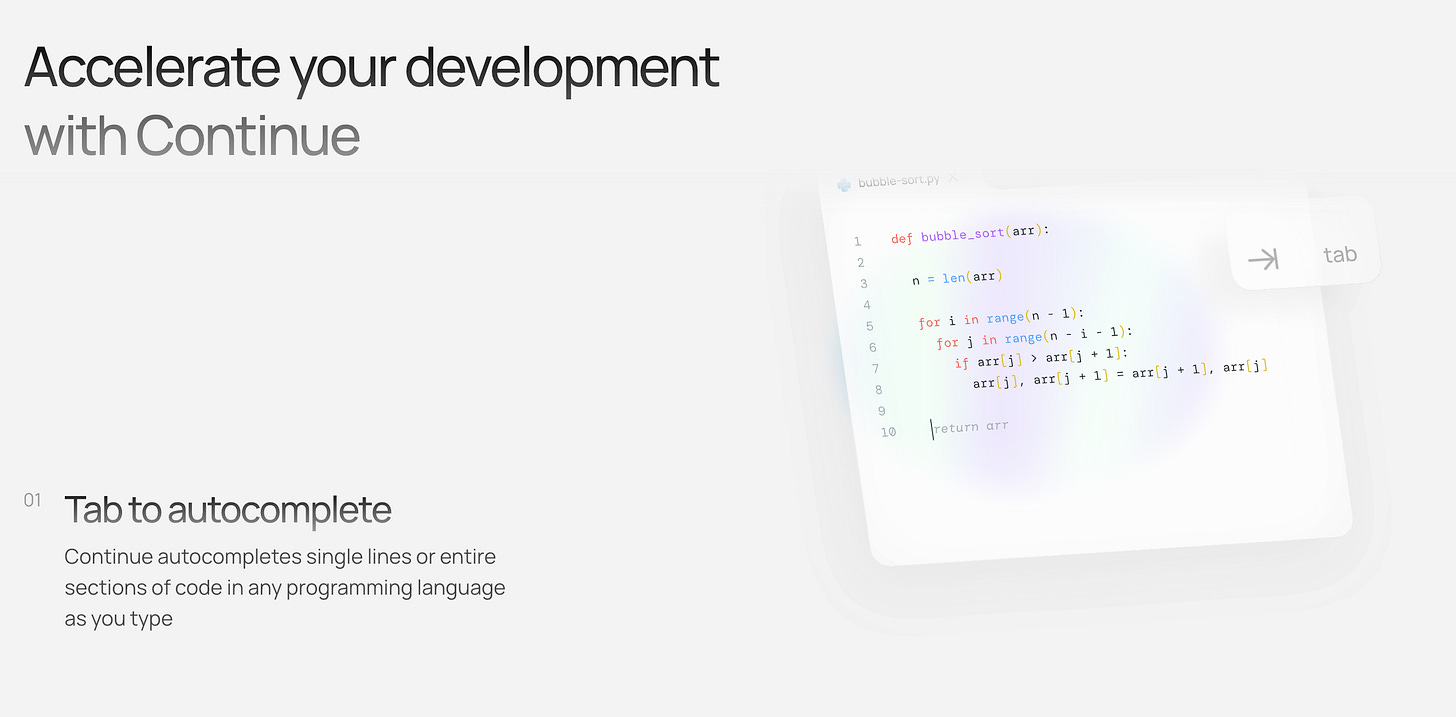

Continue:https://www.continue.dev/

Offre autocompletamento simile a GitHub Copilot

Si integra sia con Ollama che con LM Studio

Supporta configurazioni multiple dei modelli

Cline: https://cline.bot/

Funziona come un agente AI per task complessi

Supporta sia modelli locali che servizi cloud

Include funzionalità avanzate come notifiche e server MPC

L'approccio ibrido DeepSeek-R1 + Sonnet

Recenti benchmark ed esperienze degli utenti hanno dimostrato che combinando DeepSeek-R1 per la pianificazione con Claude 3.5 Sonnet per l'implementazione è possibile ridurre i costi fino al 97%, migliorando al contempo la qualità complessiva dell'output.

La capacità di Cline di passare da un modello all'altro senza soluzione di continuità rende pratico questo approccio ibrido.

Modalità Pianifica/Agisci: controlla quando è più importante

Il passaggio da Pianifica a Agisci (con il recente aggiornamento v3.2.6 di Cline) cambia radicalmente il modo in cui interagisci con l'assistenza dell'IA:

Modalità di pianificazione : progettazione e revisione delle soluzioni prima dell'esecuzione, con selezione persistente del modello

Modalità Act: implementazione diretta per attività semplici, mantenendo la propria preferenza di modello

Model Context Protocol (MCP): estensibilità in pratica

Il Model Context Protocol cambia fondamentalmente ciò che è possibile con l'assistenza AI. Invece di limitarsi a integrazioni predefinite, è possibile estendere le capacità di Cline tramite strumenti personalizzati. Alcune applicazioni pratiche:

Integrazione con sistemi di monitoraggio interni

Flussi di lavoro di scansione di sicurezza personalizzati

Generazione automatizzata della documentazione

Pipeline di modernizzazione del sistema legacy

La semplicità del protocollo (API basata su JSON) lo rende accessibile pur rimanendo abbastanza potente per integrazioni complesse, senza richiedere prompt o ruoli specializzati. Questa estensibilità è particolarmente preziosa negli ambienti aziendali in cui gli strumenti personalizzati sono la norma piuttosto che l'eccezione.

Best Practices e Consigli per l'Ottimizzazione

Scelta dell'Ambiente:

Concentratevi su un singolo strumento (Ollama o LM Studio)

Selezionate i modelli in base alle vostre esigenze specifiche

Gestione delle Risorse:

Chiudete le applicazioni non necessarie durante l'esecuzione dei modelli

Monitorate l'utilizzo delle risorse di sistema

Considerate l'uso di una macchina dedicata per i modelli più pesanti

Ottimizzazione delle Prestazioni:

Utilizzate modelli specializzati per task specifici

Bilanciate le dimensioni del modello con le capacità del sistema

Analisi Costi-Benefici

L'esecuzione locale dei modelli AI presenta vantaggi e svantaggi:

Vantaggi:

Nessun costo ricorrente

Controllo completo sulla privacy

Possibilità di lavorare offline

Maggiore flessibilità nella personalizzazione

Svantaggi:

Necessità di hardware più potente

Prestazioni potenzialmente inferiori

Maggiore complessità nella gestione

Tuttavia, se si stanno sviluppando sistemi complessi e si desidera un'assistenza di intelligenza artificiale che rispetti i principi ingegneristici, Cline merita di essere preso in seria considerazione.

Conclusioni

L'AI locale rappresenta una svolta significativa per gli sviluppatori, offrendo un controllo senza precedenti sui modelli di intelligenza artificiale. Che siate sviluppatori professionisti alla ricerca di una soluzione affidabile o entusiasti che vogliono sperimentare con i modelli AI, gli strumenti e gli approcci descritti in questa guida forniscono una base solida per lo sviluppo AI locale.

La tecnologia continua a evolversi rapidamente, e possiamo aspettarci soluzioni ancora più potenti ed efficienti per il deployment locale di modelli AI. Vi invitiamo a condividere le vostre esperienze nei commenti: quali strumenti state utilizzando per l'AI locale? Avete trovato particolari configurazioni che funzionano bene per i vostri casi d'uso? La vostra esperienza potrebbe essere preziosa per altri sviluppatori che stanno intraprendendo lo stesso percorso.